はじめに

この記事はQualiArts Advent Calendar 2025の20日目です。

はじめまして、内定者アルバイトでQualiArtsに所属しているゲームクライアントエンジニアの海道 敦也です。 QualiArtsには10月から1月まで所属する予定で、プロジェクトでは3Dサウンド周りに携わっています。

ゲームサウンド領域にとても興味があり、それを任せて頂いていることをとても嬉しく思っています。

この記事は内定者アルバイトで培ったサウンドミドルウェアの役割とその運用におけるエンジニアの関わり方についてまとめたものです。 サウンドエンジニアの業務についてとても詳しいわけではありませんが、学んだことを記載できればと思います。

この記事の対象とゴール

対象:Unityでミドルウェアを導入/運用するクライアントエンジニア、テクニカル寄りサウンド担当

ゴール:

- ミドルウェアが得意な領域/不得意な領域を整理する

- エンジニアが提供すべき「ゲーム内情報」の考え方を掴む

- 3Dサウンド運用で起きがちな課題(空間/ワークフロー)を知る

サウンドミドルウェアとは

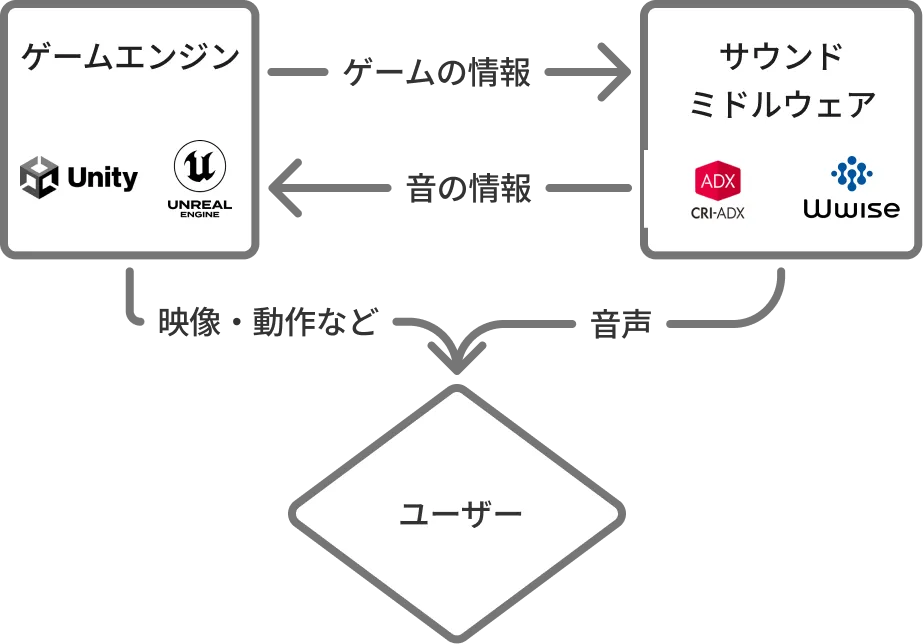

サウンドミドルウェアとは、CRI ADXやWwiseなどUnityやUnreal Engineとは別にゲームサウンドを効率的・効果的に作成するためのツールです。 ゲームエンジンに組み込んで使用し、エンジニアは組み込みを担います。

サウンドミドルウェアはなにが凄いのか

サウンドミドルウェアを利用することによって、エンジニアは音を鳴らすタイミングと鳴らす音の名前(ID)さえを知っていれば音を鳴らすことができます。 また、サウンドクリエイターさんは鳴らす音に対してフィルターや簡単なロジックなどを設定できるため、エンジニアに依頼しなくても音の調整が可能です。 このため、サウンドミドルウェアは音を鳴らすという意味では手軽で、エンジニアにサウンド固有の知識はほとんど求められません。

基本的な使い方

CRIやWwiseは公式チュートリアルが充実していますので、ぜひそちらを参考にしてください。

最適化について

サウンドの再生において、エンジニアが特殊なロジックを実装する必要があるケースはほとんどありません。 同時発音数の制御やファイルのデコードといった低レイヤーの最適化処理は、基本的にミドルウェア側が最低限の品質を担保してくれるためです。

そのため、エンジニアが実作業で意識すべきなのは、最大発音数の設定やプリロードの範囲といった「運用設定」に集約されます。 細かい最適化ロジックの構築に時間を割く必要はなく、ミドルウェアの機能を適切に設定するだけで、十分なパフォーマンスを得ることが可能です。

一方で、最適化の観点から最も考慮が必要なのは「アセットの扱い」です。 ロードのタイミング、ストリーミング再生を適用するかどうかの判断など、 リソース管理についてはエンジニアがプロジェクトの要件に合わせて慎重に設計する必要があります。

エンジニアが関わる部分

サウンドミドルウェアには、ゲームの状態をサウンドミドルウェア側に送信する機能が備わっている場合が多いです。 ADXでは「ゲーム変数」と呼ばれ、この機能を使うことで、たとえば「プレイヤーの移動速度」「現在の天候」「敵との距離」などの情報をサウンドミドルウェアに渡すことができます。

これにより、サウンドクリエイターさんはゲームの状態に応じて音を変化させることができます。たとえば「速度が上がったら足音のピッチを上げる」「雨のときは全体的にくぐもった音にする」といった設定がエンジニアの追加実装なしで可能になります。

この機能を利用するために、エンジニアはサウンドクリエイターさんが必要なゲームの情報をミドルウェアに渡すことが必要になります。

それぞれの職種が担当する領域をまとめると下の表のようになります。

| サウンドクリエイター | エンジニア |

|---|---|

| 送られてきた情報から音を鳴らす 音の調整などイテレーションを回す | サウンドミドルウェアに情報を送る (必要に応じて)コールバックや再生状態を受け取り、演出/状態管理に利用する |

C#での実装をするかミドルウェアの機能に任せるか

もともと自分が所属するプロジェクトでは距離減衰(音源から離れるほど音が小さくなる処理)などがC#での実装になっていました。 これではミドルウェアの効果が最大限発揮されません。特にプロジェクトで使用しているADXでは仮想化(音源が多すぎる場合に自動的に優先度の低い音を止める機能)など、ADXが提供する最適化の恩恵を受けられていませんでした。 そこで、C#での実装をやめ、ADXの3Dサウンド機能を使うことにしました。

これにより、サウンドのキュー(再生する音の単位)ごとに3D設定を変更でき、音として正しい設定をサウンドクリエイターが行えるようになりました。

| 改善前 | 改善後 |

|---|---|

| C#による独自実装 | ミドルウェアの機能を使う形に |

| サウンドクリエイターが距離減衰を調整できない | サウンドクリエイターが距離減衰や3D設定を調整可能に |

プロジェクトで発生しうるサウンド関連の課題

ここではサウンド運用において発生しうる問題を2つ紹介します。 ほかにも様々な課題があると思いますが、参考にしていただければと思います。

3Dサウンドにおける空間情報の課題

音源の位置やリスナーの位置に応じて音の聞こえ方を変化させるなど、3Dサウンドの基本的な機能はサウンドミドルウェアに搭載されています。 しかし、そのような機能を最大限活用できるようにするには、エンジニアが携わらなければならない作業が存在します。

サウンドミドルウェアは「空間」の情報を自動的に検知することはできませんし、ゲーム側でも保持していないことがほとんどです。 たとえば室内では音が反響する、音が建物に遮られていて回折しているなどの情報はエンジニアが意図的に検知する仕組みを実装してサウンドミドルウェアに伝える必要があります。

それ以外にも、足音が地面によって変わるようにするための情報の提供などが考えられます。 足音は地面に1つ1つ登録しておけば良いですが、膨大なオープンワールドでは非常に大変な作業になることが考えられます。 この対策についてはCEDECなどの場でも繰り返し発表されるほど、重要な課題のようです。

ワークフローの課題

ゲーム制作では大量のアセットが存在し、それを作成・ブラッシュアップしていきます。 たとえばADV(アドベンチャー)パートのシーンであれば音とアニメーションが一致している必要があります。

しかし、音はサウンドチームが担当し、ADVのアニメーションはアニメーションチームが担当する、といった場面も多いです。

たとえばアニメーションチームがADVをブラッシュアップした場合サウンドも修正する必要があるとなるとブラッシュアップコストは高くなります。 これに対して、アニメーションにそって自動的に音を鳴らすという技術があればコストは低下します。 このような場合に、エンジニアによる効率化が求められる可能性が生まれます。

またアウトゲームでは、特定の動作をした時にサウンドフィルターをかけたり特定のサウンドを鳴らしたりすることがあります。 この場合、エンジニアの組み込みが完了するまでサウンドクリエイターさんが絵と音を見た上での調整を行うことができません。 改善と実装を繰り返すことの速度は非常に大事になってくるため、課題になる可能性があります。

ゲームサウンドに対する向き合い方

ゲームサウンドの実装には、大きく分けてサウンドを作ることとサウンドを組み込むことの2つの工程があります。素晴らしいサウンドを作成しても、組み込み方が甘ければうまくいきません。 逆も同じです。

サウンドはゲームにとって必ずしも表に出やすい分野ではないかもしれません。 また、サウンドミドルウェアが基本的なものをやってくれるからこそ、ゲームサウンドに向き合う機会は少ないかもしれません。

しかしゲームサウンドは、ゲーム体験に対しての+αの効果はとても高いものだと思っています。 ミドルウェアを使いより良いサウンド体験を構築するため、「ゲーム内の情報」をどう渡すかについて、エンジニアはしっかり向き合っていく必要があると思います。

おわりに

この記事ではサウンドミドルウェアの役割とエンジニアの関わり方について事例を踏まえて紹介しました。

サウンドミドルウェアは膨大な機能を持っており、その理解はとても大変です。 サウンドでこういった表現をしたいという事例が出てきたら、サウンドミドルウェアの機能を探してみるというところから始めるのが良いのかもしれません。

ミドルウェアは“音作り”を強力に支援してくれる一方、ゲームの状態や空間情報をどう設計して渡すかはエンジニアの責務です。 サウンド体験によってゲームを押し上げる鍵は、この境界を理解して実装していくことだと学びました。